研究不同直播协议

我们将会详细介绍这些协议的工作原理、应用场景、及延迟的原因。

我们按这样的顺序讨论

1、 RTMP、HTTP-FLV

2、 HLS

3、 Web-RTC

4、 RTSP

RTMP、HTTP-FLV协议

RTMP和HTTP-FLV都是建立在FLV封装之上的。

RTMP一般用作直播源推流,HTTP-FLV一般用作直播观看。

我们先讨论RTMP,RTMP协议是既可以推流、也可以拉流的协议。

RTMP地址是rtmp://开头的,且推流地址与播放地址是一样的。

但是由于浏览器摒弃了Flash播放器,而且据说高并发下可能会出现一些不稳定的问题,所以RTMP一般只用作直播源推流、推流到直播CDN等场景。

RTMP协议需要特定的流媒体服务软件,如SRS、加入了RTMP插件的Nginx等。

在往期直播工作原理中讨论过,此类流媒体服务软件实际上就是音视频数据的中转站,数据一般只在内存中循环覆盖,不会写入磁盘。

RTMP协议的延迟是比较低的,大概在1-3秒左右。

RTMP通信是建立在TCP长连接通道上的,在封装音视频数据时会强制切片,限制每个数据包的大小。

强制切片也一定程度保证了实时性。有一定的弱网抵抗能力,因为每个数据包都不会太大,所以当某个数据包校验失败时,重新发送的成本不会太大,但也由于合并数据包会加大CPU压力,所以是有一定的性能消耗的。

RTMP协议还有一些变种协议,如RTMPT、RTMPS等,这里不作展开讨论。

我们再讨论HTTP-FLV协议。

地址是http://开头的,是基于HTTP协议的HTTP-FLV可以简单地理解为RTMP的HTTP协议版本。功能和工作原理上是相似的,上面提到的RTMP切片数据功能HTTP-FLV也是有的。

但是,HTTP-FLV协议一般只能用作拉流观看。

HTTP-FLV协议的延迟也是比较低的,大概在1-3秒左右,但实际体验下来 HTTP-FLV延迟会略高于RTMP,但是HTTP-FLV相对RTMP适配更多的播放场景。

HTTP-FLV直播流一般需要需加入插件才能播放,如网页需要引入flv.js后,浏览器才能播放。HTTP-FLV直播流,这里需要特别感谢B站开源的flv.js,它促进了HTTP-FLV在浏览器的普及。

HTTP-FLV协议需要特定的流媒体服务软件,如加入了HTTP-FLV插件的Nginx等。

值得一提的是,Nginx的HTTP-FLV插件是包含RTMP功能的,所以一般HTTP-FLV的流媒体服务,推流是以RTMP协议,拉流是用HTTP-FLV协议。

HTTP-FLV协议需要特定的流媒体服务软件,如加入了HTTP-FLV插件的Nginx等。

值得一提的是,Nginx的HTTP-FLV插件是包含RTMP功能的,所以一般HTTP-FLV的流媒体服务,推流是以RTMP协议,拉流是用HTTP-FLV协议。

HLS协议

HLS协议一般只用作拉流观看,但是从严格意义上讲,HLS协议并不是流式协议。

它工作原理很简单,就是通过HTTP协议下载静态文件。

不同的是,HLS协议的文件由两部分组成,一是多个只有几秒长度的.ts碎片视频文件,另一个是记录这些视频文件地址的.m3u8索引文件,且这些静态文件都是直接写入磁盘的。

更具体的说,HLS观看地址是以http://开头、.m3u8结尾的,实际上这个地址就是索引文件的地址,客户端获取到索引文件后,就可以下载对应的碎片视频文件并开始播放了。

由于HLS协议实际上是通过HTTP协议请求文件的,且HLS相关文件是直接写入磁盘的,所以并不需要特殊的流媒体服务软件,使用Nginx等HTTP服务就可以了。

HLS协议可以用于点播和直播观看,其适配多种播放场景,一般加入插件就可以播放了,如网页加入HLS的js插件就可以播放了,苹果设备是原生支持HLS协议的。

点播的场景下,也就是普通网络视频观看的场景下。

.m3u8索引文件会记录所有的碎片视频文件地址,HLS在点播的场景下,优势是更加明显的。

由于HLS的相关文件是无状态的静态文件,且每个文件的大小是有限的,所以负载均衡、CDN加速的效果更佳明显。

HLS协议的点播视频,会比.mp4、.flv的视频更快地播放出来,且在加载中跳转视频也会更加顺滑。

直播的场景下,转码软件可以直接生成HLS相关文件到磁盘,客户端通过HTTP服务下载文件即可。

另外,也可以在Nginx加入RTMP插件,转码软件以RTMP协议推流到Nginx,再由Nginx生成HLS相关文件。

其中,后一种方案更加推荐,因为它对于前期研发和后期对接直播CDN的过度更加顺滑。

另外,直播场景下的HLS相关文件与点播是有些不同的。

视频流数据每几秒会打包成一个以.ts为后缀的碎片视频文件,每生成一个新的视频文件都会同步更新.m3u8索引文件。

且碎片视频文件的个数是有上限的,当达到上限后,默认会将最旧的视频文件删除且更新.m3u8索引文件。

所以在直播的场景下,客户端也需要不断定时重新获取.m3u8索引文件。

HLS协议在直播的场景下是没什么优势的。

虽然HLS协议的直播流也可以适配很多播放场景,但是由于需要生成静态文件,直播延迟很大,大概在5-30秒左右,使用直播CDN的话,由于边缘节点同步等问题,直播延迟甚至可能会达到1分钟左右。

当然HLS协议也有一定的优势,在直播时移,也就是直播转点播,或者录播,也就是点播转直播的场景, 理论上只需要修改索引文件就可以了。另外,HLS协议的.m3u8索引文件支持二级索引,就是高清、标清、流畅等多个观看地址可以整合到一个索引文件。播放器可以根据当前带宽自动切换不同的观看地址,大部分网页播放器的“自动”也是因为这个。

这里补充一个HLS协议的小知识点。

由于HLS协议的视频文件、索引文件都是直接写入磁盘的 ,所以如果长时间且多个直播流同时处理,会造成磁盘写入压力过大,机械磁盘可能会磁道会损坏,固态硬盘的寿命会加速衰减。

这种情况下,最好挂载一段内存空间作为HLS相关文件的写入位置,则不会造成磁盘写入压力过大的问题。

补充说明一下,HLS协议是苹果推出的标准,与HLS协议类似的还有MPEG-DASH协议 HLS、MPEG-DASH的工作原理都是差不多的,只是局部标准不一样,这里不作展开。

WebRTC协议

WebRTC协议其实并不是为了直播场景而设计的,WebRTC是一种点对点的视频/语音通话协议。

由于WebRTC是基于UDP的,建立通信后,会不断以流式发送数据,所以延迟会比RTMP还要低。

在一些交互性较高的直播场景,如直播带货等场景,会使用WebRTC作为推流和观看协议 WebRTC的延迟理论上可以达到1秒内。

WebRTC协议支持推流和拉流,地址一般是以webrtc://开头的,且推流和拉流地址一般也是一样的。

WebRTC虽然是点对点的协议,但是应用在直播场景的话,是需要搭建WebRTC服务器作为流媒体服务的,流媒体服务软件可以使用SRS。这里顺便一提,SRS是国内研发的一个比较流行的开源流媒体服务软件,目前4.0已经囊括了RTMP、HLS、WebRTC、HTTP-FLV等主流协议。

RTSP协议

RTSP一般不用作直播场景,RTSP一般用作摄像头、监控等硬件设备的实时视频流观看与推送上。

尽管RTSP协议也支持推流/拉流,且支持TCP、UDP切换以及其他诸多优点。

但是泛用性不足,特别是现在的浏览器都不支持RTSP的播放。

总结

以上是常用的直播协议的介绍,其中提到的延迟都是单纯的通信延迟,如果要放眼整个直播流程,延迟将会进一步放大。

因为直播延迟包括推流延迟、转码延迟、拉流延迟,即使使用WebRTC作为推流和拉流协议,最终的延迟也会有几秒的延迟。

至于直播延迟的问题,虽然以上协议起了关键作用,但是往往起不到绝对作用。

直播延迟的降低,会涉及到很多问题。如禁止B帧、GPU硬件加速、流媒体服务缓存I帧、码率限制等等细节问题,后续我们会出具体内容详细讨论。

目前主流几项自建直播平台方案

- 流媒体解决方案 Live555 (C++)

- 流媒体平台框架 EasyDarwin (C++,国产精品)

- 实时流媒体播放服务器程序DarwinStreamingSrvr (C++)

- Flash流媒体服务器 Red5 (Java)

- 流媒体服务器 Open Streaming Server (Java)

- FMS流媒体服务器 (Adobe,收费的)

- Wowza流媒体服务器(Java)

- 开源流媒体平台FreeCast(Java)

- Ngix+RTMP插件

- SRS+OBS

这里介绍国产开源流媒体服务器 SRS 项目

1.SRS简介

SRS(Simple Realtime Server)是一个简单高效的实时视频服务器, 是国人写的一款非常优秀的开源流媒体服务器软件,可用于直播/录播/视频客服等多种场景,其定位是运营级的互联网直播服务器集群。

支持RTMP/WebRTC/HLS/HTTP-FLV/SRT/GB28181协议。

官方网站:http://ossrs.net/lts/zh-cn/

目前版本为SRS4,属于稳定版,可用于生产环境

2.SRS安装

官方教程文档:Docker | SRS (ossrs.net)

安装主要有docker和源码安装,两种方式,都很简单。

官方推荐使用Docker启动SRS,这是最简单也是最方便的方式。 由于后续有些内容经常需要动到配置文件,所以我这里选择用源码安装的方式。

1:下载源码git clone -b 4.0release https://gitee.com/ossrs/srs.git

2:编译,注意需要切换到srs/trunk目录

cd srs/trunk ./configure make

3:启动服务器

./objs/srs -c conf/srs.conf

4:检查服务器状态 检查SRS是否成功启动,可以打开 http://localhost:8080/ ,如我这里服务器地址为:192.168.152.100。所以浏览器输入:http://192.168.152.100:8080/即可访问。

当然,也可以用命令检查服务器状态。

./etc/init.d/srs status

或者看SRS的日志

tail -n 30 -f ./objs/srs.log

如下图,看到下面提示为正常启动。

SRS(pid 29588) is running. [ OK ]

三、OBS推流RTMP

推流可以选择FFmpeg或者OBS,如果对FFmpeg命令比较熟,可以选择这个,占用资源更少。

我这里选择OBS,因为界面话更友好直观。

OBS下载地址:https://obsproject.com/download

1:直播画面选择

在来源+中,选择要推送的画面,如果有摄像头或者摄像机,则添加“视频采集设备”,然后选择相应的摄像头名称即可。

我这里没摄像头,选择自己的电脑桌面直播推送,及“显示器采集”。

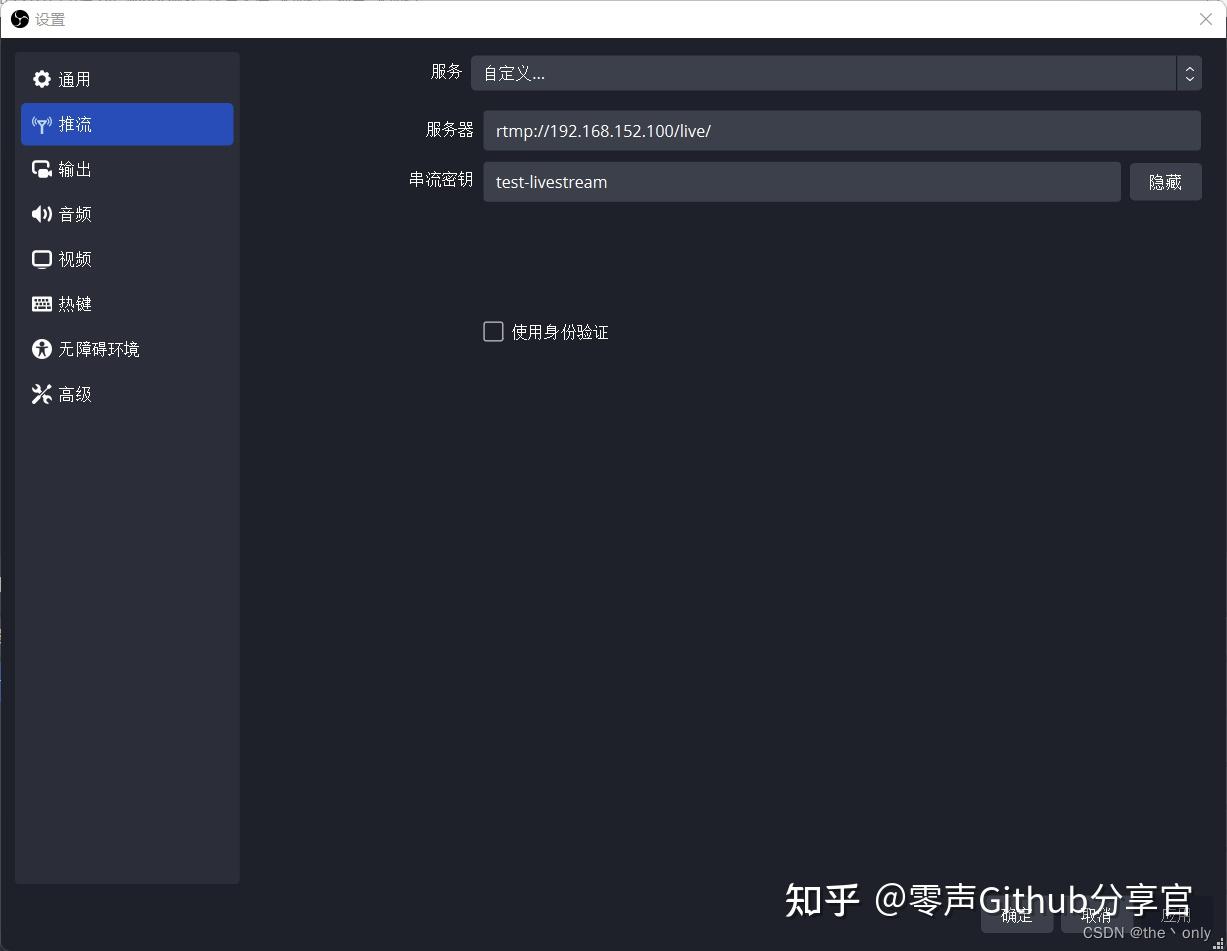

2:设置流媒体服务器

在右下方的 设置 >> 推流 >> 服务 >> 自定义。

填写流媒体服务器地址,我这里是: rtmp://192.168.152.100/live/ 串流密钥随便填写即可,这里我填写的是:test-livestream。 所以最后播放地址为:rtmp://192.168.152.100/live/test-livestream

3:推送直播画面

配置完成后,点击 “开始推流” 即可推送画面。没有报错,说明推送成功,同时下方会有相关信息,如cpu之类的。

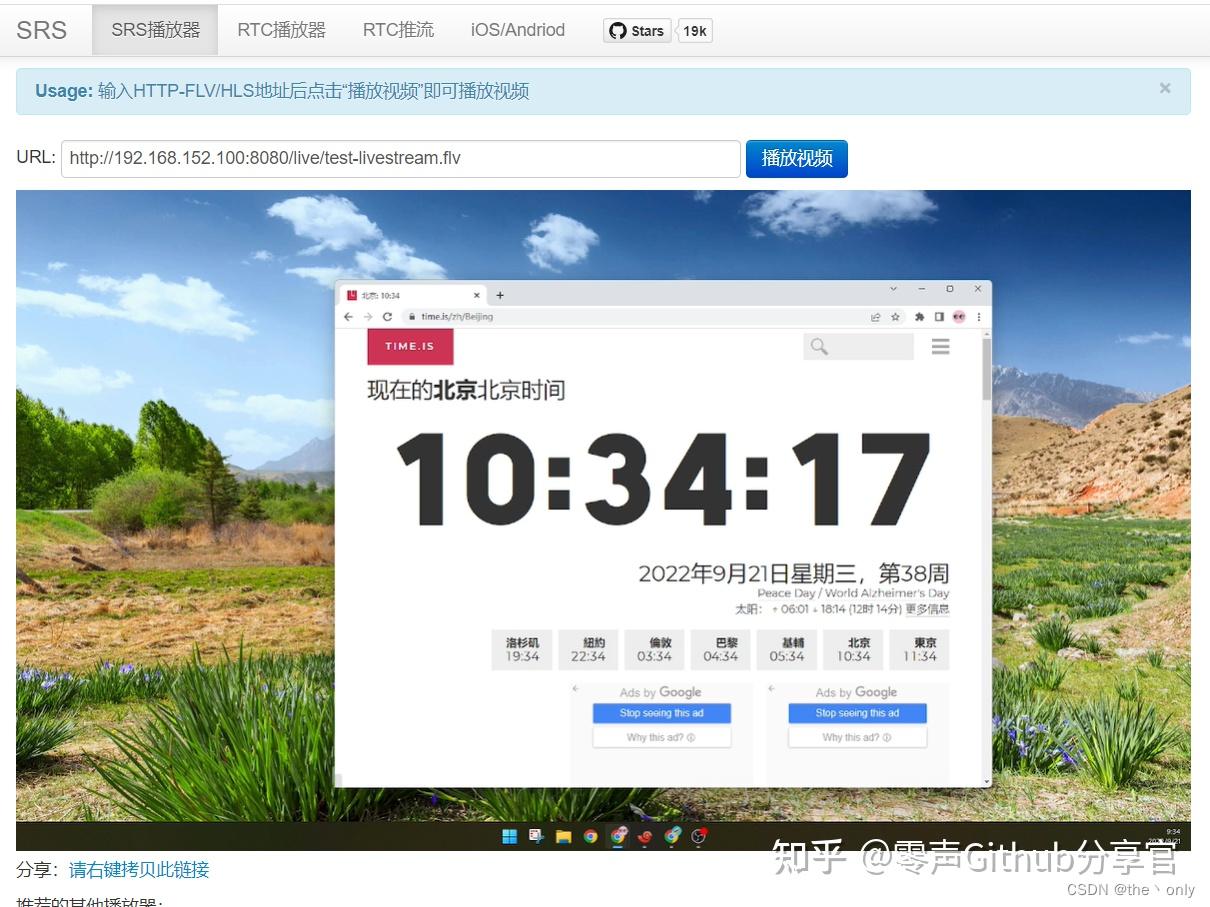

在浏览器 http://192.168.152.100:8080/ 打开控制台,可以看到推送的流信息。

点击预览,可以看到,刚才的推送画面了。后面加flv,是因为推流拉流都是用的RTMP。 所以RTMP流的播放地址为:rtmp://192.168.152.100/live/test-livestream.flv

【文章福利】小编整理了一些音视频学习资料包、大厂面试题、技术视频和学习路线图,包括(C/C++,Linux,FFmpeg webRTCrtmp hlsrtsp ffplay srs 等等资料)有需要的可以点击994289133加群免费领取哦

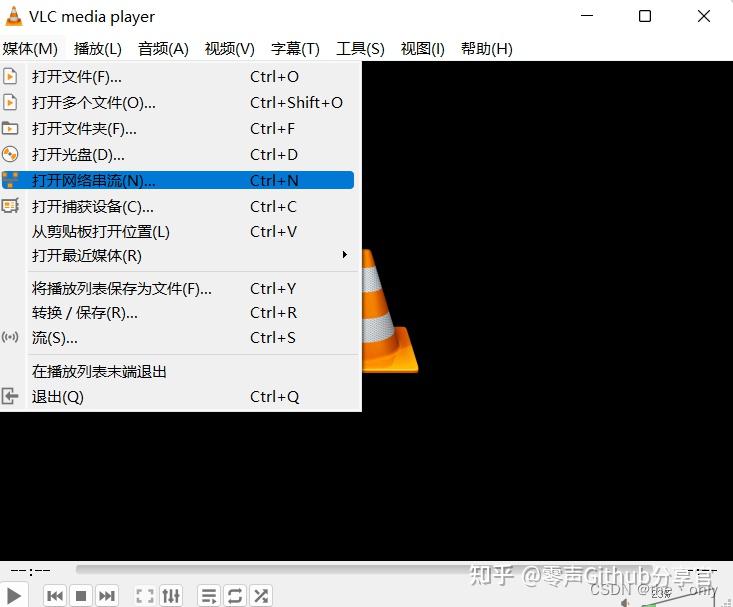

4:VLC 播放器

VCL是一个很强大的播放器,支持播放网络串流。

所以可以直接用VCL播放测试。

下载地址:https://www.videolan.org/index.an.html

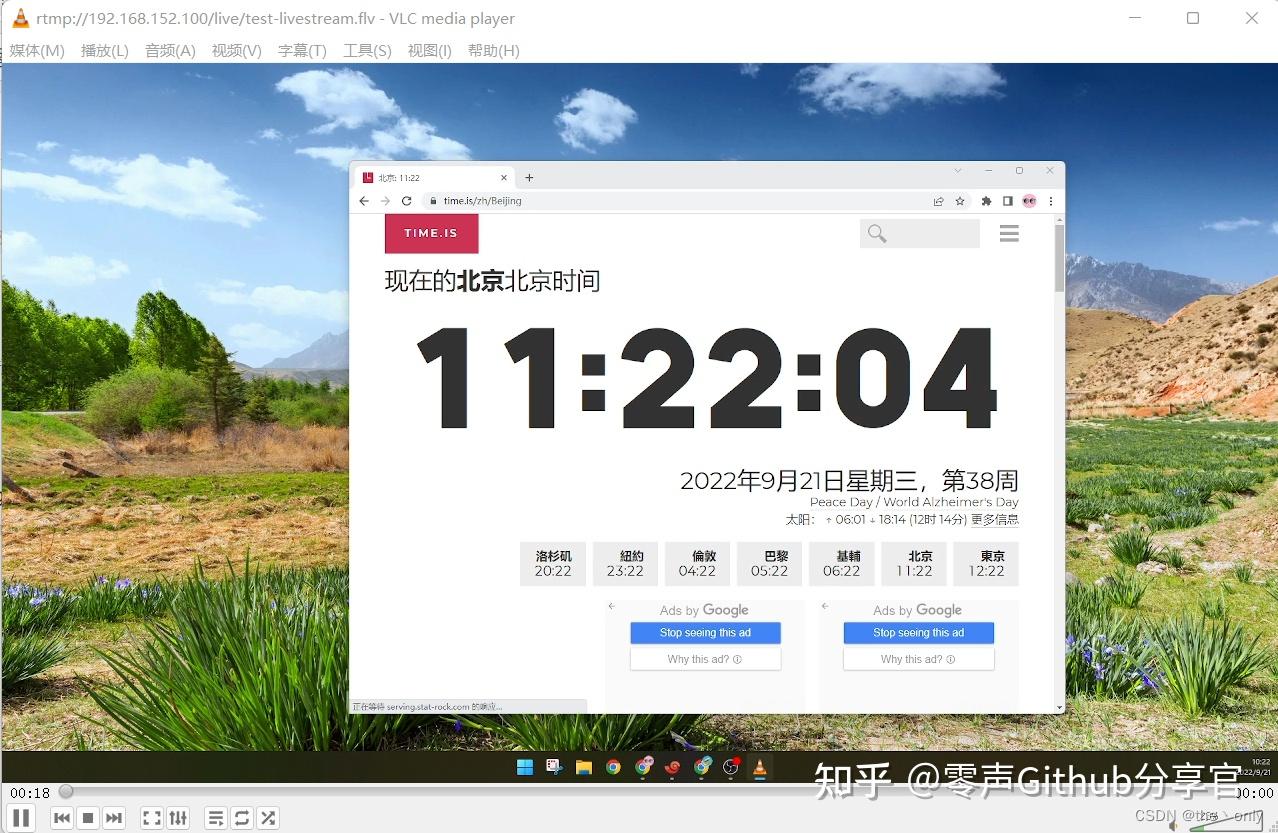

下载安装后,打开 媒体 >> 打开网络串流,输入播放地址即可观看直播画面。

四、RTMP低延时配置

以上基本的直播推流拉流,配置完成。但是测试,延迟还是很大。

根据直播画面和本地时间对比,可以发现延迟差不多有6秒左右,不是很正常。RTMP流,正常延迟时间为1到3秒左右,所以还需要配置。

1:默认配置文件

由于我们以默认的配置文件启动,即srs.conf 这个配置文件。默认配置文件如下:

``` ubuntu@ubuntu:~/srs/trunk$ cat conf/srs.conf

main config for srs.

@see full.conf for detail config.

listen 1935; max_connections 1000;

srslogtank file;

srslogfile ./objs/srs.log;

daemon on; httpapi { enabled on; listen 1985; } httpserver { enabled on; listen 8080; dir ./objs/nginx/html; } rtcserver { enabled on; listen 8000; # UDP port # @see https://ossrs.net/lts/zh-cn/docs/v4/doc/webrtc#config-candidate candidate $CANDIDATE; } vhost defaultVhost { hls { enabled on; } httpremux { enabled on; mount [vhost]/[app]/[stream].flv; } rtc { enabled on; # @see https://ossrs.net/lts/zh-cn/docs/v4/doc/webrtc#rtmp-to-rtc rtmptortc off; # @see https://ossrs.net/lts/zh-cn/docs/v4/doc/webrtc#rtc-to-rtmp rtctortmp off; } }```

2:更改配置文件

根据官方文档,可以更改配置文件,低延迟配置,在vhost __ defaultVhost __ 添加以下配置。具体原理可以参考官方文档。

``` tcpnodelay on; minlatency on;

play {

gop_cache off;

queue_length 10;

mw_latency 100;

}

publish {

mr off;

}

```

最终配置文件为:

``` listen 1935; max_connections 1000;

srslogtank file;

srslogfile ./objs/srs.log;

daemon on; httpapi { enabled on; listen 1985; } httpserver { enabled on; listen 8080; dir ./objs/nginx/html; } rtcserver { enabled on; listen 8000; # UDP port # @see https://ossrs.net/lts/zh-cn/docs/v4/doc/webrtc#config-candidate candidate $CANDIDATE; } vhost defaultVhost { hls { enabled on; } httpremux { enabled on; mount [vhost]/[app]/[stream].flv; } rtc { enabled on; # @see https://ossrs.net/lts/zh-cn/docs/v4/doc/webrtc#rtmp-to-rtc rtmptortc off; # @see https://ossrs.net/lts/zh-cn/docs/v4/doc/webrtc#rtc-to-rtmp rtctortmp off; } tcpnodelay on; minlatency on;

play {

gop_cache off;

queue_length 10;

mw_latency 100;

}

publish {

mr off;

}

}

```</div>

<h3><b>3:重载配置文件测试</b></h3>

<p data-pid="UIAARLrc">配置完成后,reload重载配置,完成。</p>

<p data-pid="6TnOurgV"><code>./etc/init.d/srs reload</code></p>

<p data-pid="tAUN4Xwc">然后再次用obs推流拉流,查看效果,延迟为2秒左右,在正常延迟范围内。</p>

<figure data-size="normal">

<div><img class="origin_image zh-lightbox-thumb lazy" src="https://pic3.zhimg.com/80/v2-823451230a67393f865e868e7a8c6136_1440w.webp" width="1730" height="808" data-caption="" data-size="normal" data-rawwidth="1730" data-rawheight="808" data-original="https://pic3.zhimg.com/v2-823451230a67393f865e868e7a8c6136_r.jpg" data-actualsrc="https://pic3.zhimg.com/v2-823451230a67393f865e868e7a8c6136_b.jpg" data-original-token="v2-220ddd9c2819d9af003533d878aedd89" data-lazy-status="ok" /></div></figure>

<h2><b>五、RTMP推流webRTC拉流(RTMP to RTC)</b></h2>

<p data-pid="oPfH1DTf">上面测试有2秒的延迟,有没有更低延迟呢。有,就是webRTC。</p>

<p data-pid="fctN4NaM">webRTC起初用于视频会议等及时通讯,现在越来越成熟,应用也越多,正常延迟为1秒之内。</p>

<p data-pid="45BG37N1">1:更改配置文件 默认配置文件,有rtc的选项,是打开的,我们是RTMP to RTC,所以还需要把rtmp<i>to</i>rtc off 改成 rtmp<i>to</i>rtc on,即可。</p>

<div class="highlight">

<pre><code class="language-text">``` rtc { enabled on; # @see https://ossrs.net/lts/zh-cn/docs/v4/doc/webrtc#rtmp-to-rtc rtmptortc on; # @see https://ossrs.net/lts/zh-cn/docs/v4/doc/webrtc#rtc-to-rtmp rtctortmp off; }

```

还有重要的一点,rtc_server里的candidate配置。如果是服务器是云服务器之类的。必须将 $CANDIDATE 更改为公网IP,或者0.0.0.0(任何IP可访问)。我这里内网测试,所以无需更改。

rtc_server { enabled on; listen 8000; # UDP port # @see https://ossrs.net/lts/zh-cn/docs/v4/doc/webrtc#config-candidate candidate $CANDIDATE; }

2:重载配置测试

./etc/init.d/srs reload

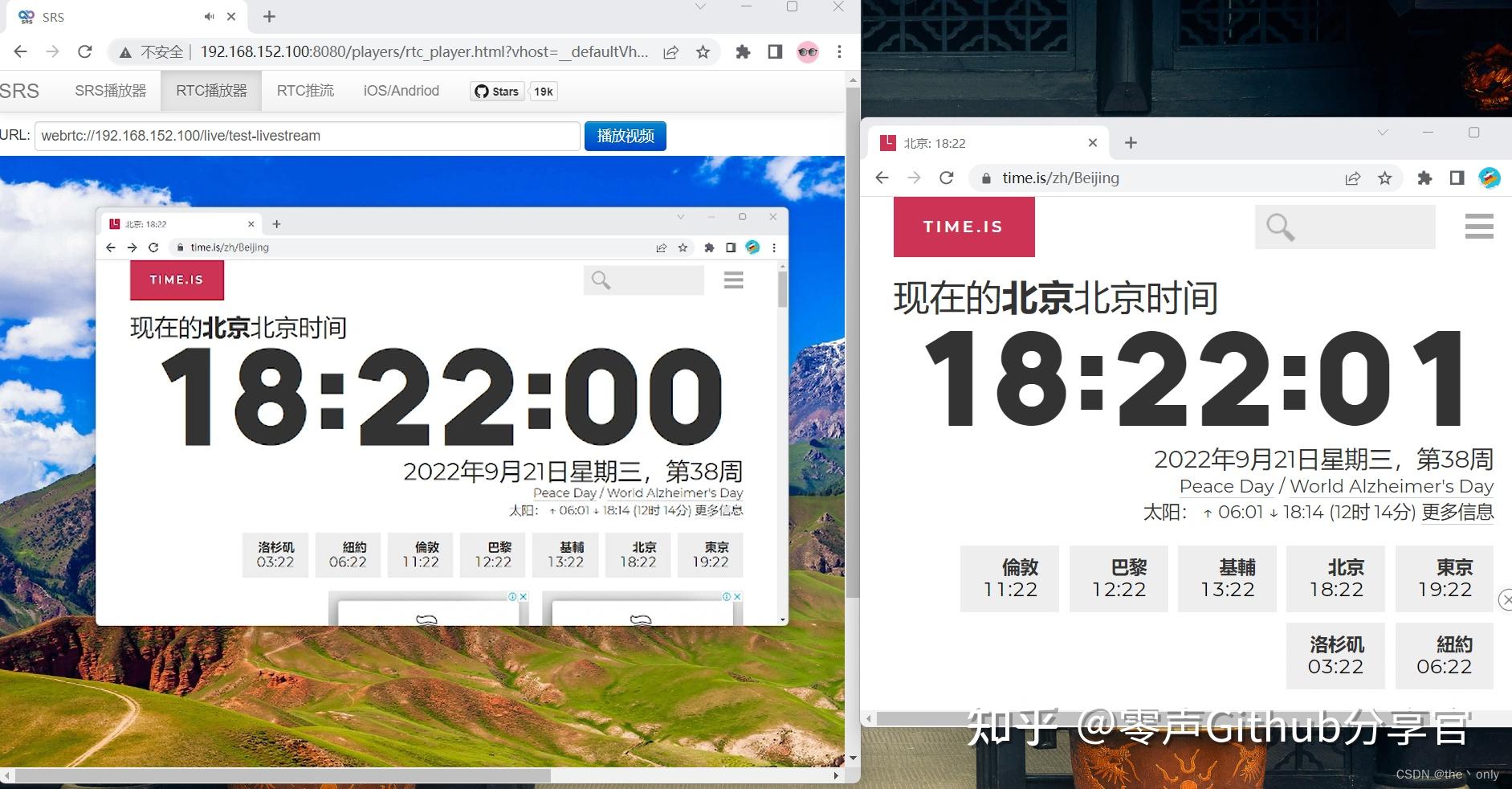

由于vcl不支持webRTC格式串流,所以直接用控制台自动的webRTC播放器查看。 播放地址为:webrtc://192.168.152.100/live/test-livestream

同时打开直播画面和本地画面。

可以看到延迟在1秒之内,基本在500毫秒左右。

六、HLS流

HLS流,作为直播正常延迟10秒起步,所以也不推荐使用。如果要配置。 只需在默认配置文件中,添加如下即可,原来只有一行

enabled on;

``` hls { enabled on; hlspath ./objs/nginx/html; hlsfragment 10; hls_window 60; }

```</code></pre>

</div>

<p data-pid="h5A6_o4k">重载配置后,可用vcl播放器地址:<a class=" external" href="https://link.zhihu.com/?target=http%3A//192.168.152.100%3A8080/live/test-livestream.m3u8" target="_blank" rel="nofollow noopener noreferrer" data-za-detail-view-id="1043"><span class="invisible">http://</span><span class="visible">192.168.152.100:8080/li</span><span class="invisible">ve/test-livestream.m3u8</span></a></p>

<p data-pid="FcchJOY4">延迟太大,可自行测试。</p>

<h2><b>七、DVR录制</b></h2>

<p data-pid="p8wCsrz6">OBS也可以直接录制,但是有些需求,需要在服务器上直接录制文件,如API需求,所以在服务器开启DVR即可。</p>

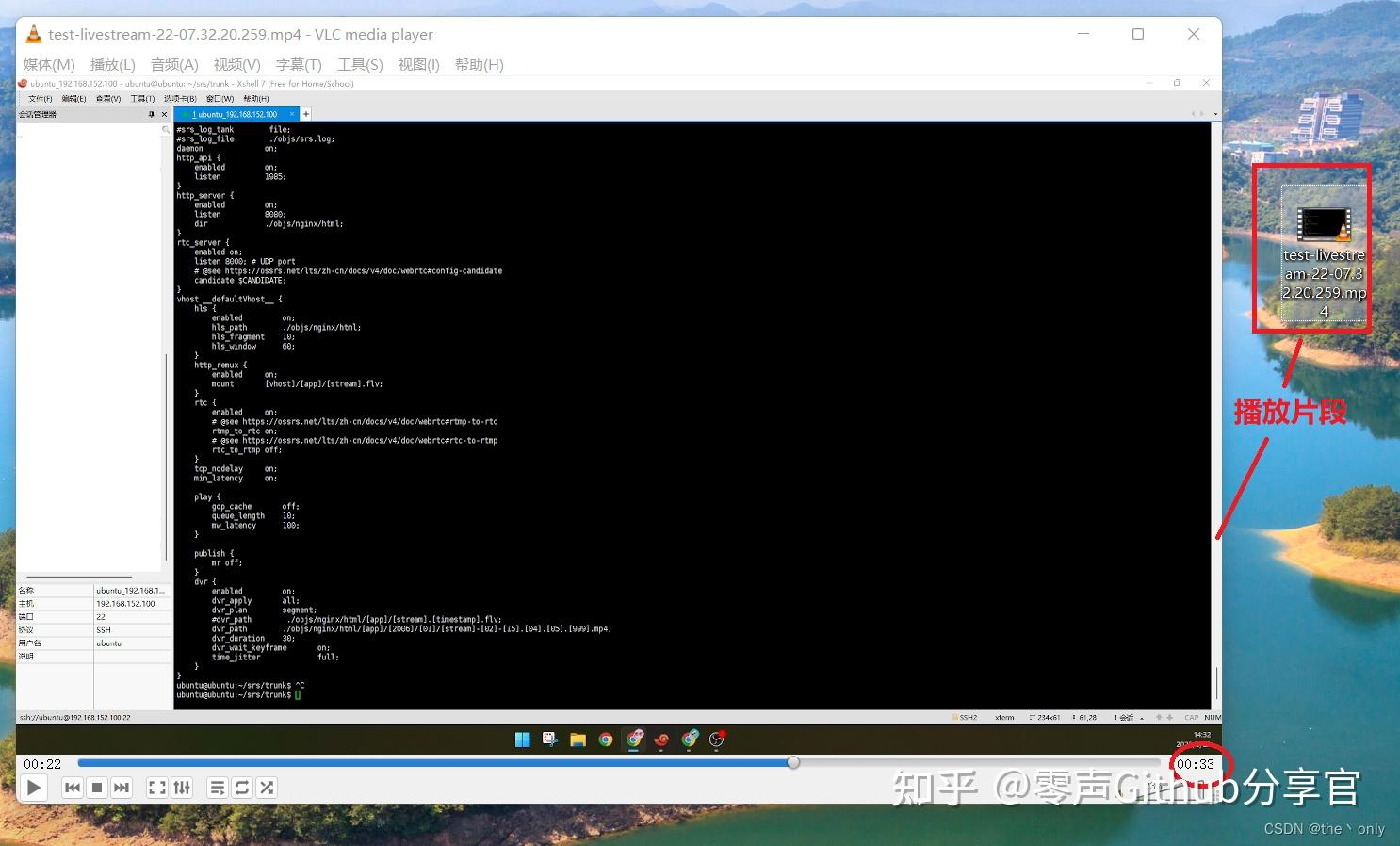

<p data-pid="NKUWCQ_u">1:更改配置文件 SRS支持将RTMP流录制成FLV或MP4文件。 DVR作为SRS3的核心功能,永远开启DVR,只需要在配置文件的 vhost defaultVhost 加入以下内容即可</p>

<div class="highlight">

<pre><code class="language-text">``` dvr { enabled on; dvrapply all; dvrplan segment; dvrpath ./objs/nginx/html/[app]/[2006]/[01]/[stream]-[02]-[15].[04].[05].[999].mp4; dvrduration 30; dvrwaitkeyframe on; time_jitter full; }

```参数说明:

dvrapply :DVR的apply决定了是否对某个流开启dvr,默认的all是对所有开启

dvrplan :可配置session和segment,session就是推流到停止推流为整段视频保存,dvrduration参数不生效。segment为分段报错,和dvrduration、dvrwaitkeyframe搭配使用。

dvrduration:录制每个片段时常,如30,为30秒一个片段。

dvrwaitkeyframe:按关键帧切。

timejitter: 时间戳抖动算法。full使用完全的时间戳矫正;zero只是保证从0开始;off不矫正时间戳。

dvrpath :文件报错路径及命令方式。

自定义DVR的路径和文件名 以上默认即可,

主要参数: dvrpath 按自己需要改格式。

1:没有变量,SRS1.0方式(自动添加[stream].[timestamp].flv作为文件名):

dvr_path ./objs/nginx/html/[app]/[stream].[timestamp].flv;生成的文件名及路径:

./objs/nginx/html/live/livestream.1420254068776.flv; ```2:按流和年月日分目录,时间作为文件名

``` dvr_path ./objs/nginx/html/[app]/[stream]/[2006]/[01]/[02]/[15].[04].[05].[999].flv;生成的文件名及路径:

./objs/nginx/html/live/livestream/2015/01/03/10.57.30.776.flv; ```3:按流和年月分目录,日和时间作为文件名:

``` dvr_path ./objs/nginx/html/[app]/[stream]/[2006]/[01]/[02]-[15].[04].[05].[999].flv;生成的文件名及路径:

./objs/nginx/html/live/livestream/2015/01/03-10.57.30.776.flv; ```4:按vhost/app和年月分目录,流名称、日和时间作为文件名:

``` dvr_path ./objs/nginx/html/[app]/[2006]/[01]/[stream]-[02]-[15].[04].[05].[999].flv;生成的文件名及路径:

./objs/nginx/html/live/2015/01/livestream-03-10.57.30.776.flv; ```5:按app分目录,流和时间戳作为文件名(SRS1.0方式):

``` dvr_path ./objs/nginx/html/[app]/[stream].[timestamp].flv;生成的文件名及路径:

./objs/nginx/html/live/livestream.1420254068776.flv; ```如果需要录制MP4格式的,就把flv后缀,改成mp4即可。

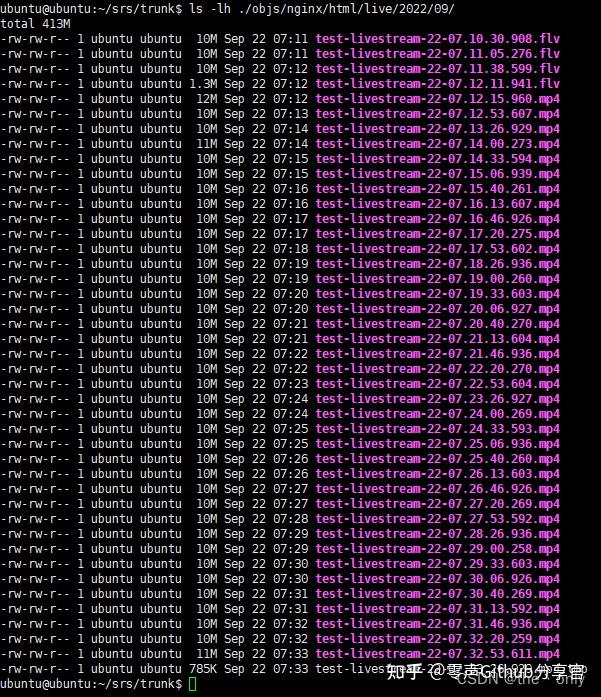

3:查看录制的文件

改成后重载配置

./etc/init.d/srs reload

过一段时间,可以在./objs/nginx/html/live/2022/09/ 看到生成的文件。

下载任意一个文件,播放可以看到录制的时间30秒左右。

4:Http Callback

服务器端定制的实现方式,就是HTTP回调。如需要api回调的方式获取dvr,在配置文件加入以下即可。

http_hooks { enabled on; on_dvr http://127.0.0.1:8085/api/v1/dvrs; }

更详细的可自行参考官方文档:HTTP Callback

八、小结

以上基本的使用及搭建就完成了,如果还需要功能可自行参考官方文档。

引用官方的那句话:

对于新手来说,音视频的门槛真的非常高,SRS的目标是降低(不能消除)音视频的门槛,所以请一定要读完Wiki:https://ossrs.net/lts/zh-cn/docs/v4/doc/introduction

文章评论